🏰 💥 AMD, bientôt la chute ? 🧐

👉 Idem pour Nvidia ?

🇺🇸 AMD, bientôt la chute ? : Ma réflexion sur AMD (et Nvidia) avec tous les éléments dont je dispose.

Temps de lecture : 16 mins.

Pour rappel, si vous avez trouvé cette édition utile, n’hésitez pas à cliquer sur le petit cœur 💚 (sous le titre), cela m’encourage énormément et me permet de savoir ce qui vous intéresse 🙏 !

🇺🇸 Ma réflexion sur AMD

Identité

Capitalisation : 195 Mrds$

Place de cotation : Nasdaq 🇺🇸

Isin : US0079031078

Éligibilité au PEA : Non

🎙 Version audio

🎓 Présentation

Quand j’analyse des jeunes entreprises, ou des entreprises de croissance, j’essaye tout d’abord de comprendre le problème que ces entreprises résolvent.

Comme je le dis souvent, une entreprise fait soit gagner de l’argent, soit du temps, soit de l’estime de soi ou du bien être.

Dans le cas d’AMD, c’est assez simple.

AMD vend des produits qui permettent de faire gagner de l’argent et du temps à ses clients.

AMD vend plus précisément des composants électroniques qui permettent à leurs clients d’être plus rapides pour réaliser des tâches, généralement liées au calcul informatique.

Passons à une présentation plus formelle.

Les quatre principaux segments d'activité d'AMD étaient les suivants en 2023 :

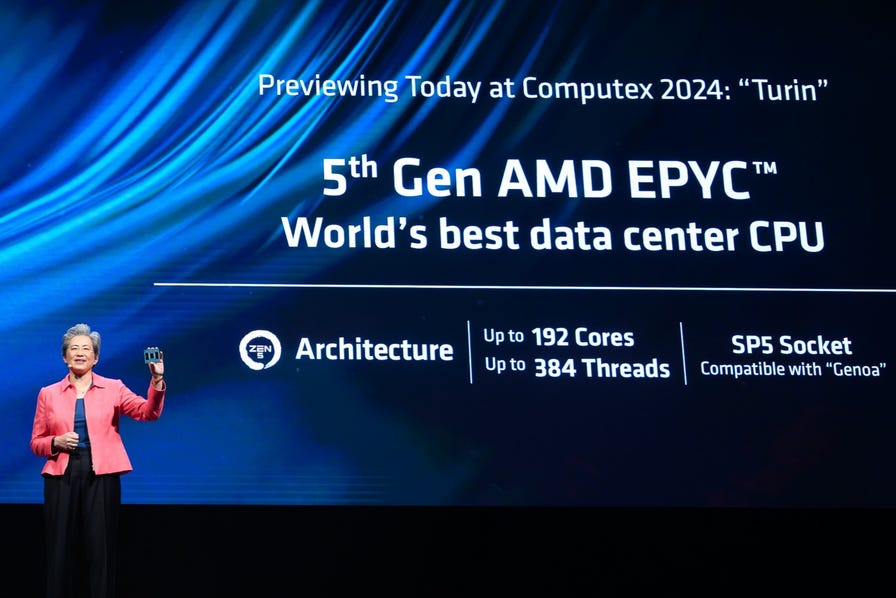

Data Center (29% des ventes) : Ce segment inclut les processeurs de serveur (comme les séries AMD EPYC), les GPU pour centres de données, les accélérateurs d'IA, les DPU (Data Processing Units), les SoC adaptatifs, les FPGA (Field Programmable Gate Arrays), et les SmartNIC (cartes d'interface réseau intelligentes). Ces produits sont conçus pour répondre aux besoins d'accélération des charges de travail de calcul, de traitement des données visuelles et d'IA sur le marché des centres de données.

Client (21%) : Comprend principalement les processeurs pour ordinateurs de bureau et portables, notamment les CPU Ryzen pour les PC clients. Ce segment se concentre sur les marchés des PC personnels et professionnels, offrant des solutions pour les utilisateurs finaux et les entreprises.

Gaming (27%) : Ce segment se concentre sur les produits destinés au marché du jeu vidéo, y compris les processeurs graphiques (GPU) Radeon pour les cartes graphiques de jeu, ainsi que les semi-custom SoC utilisés dans les consoles de jeux comme la PlayStation et la Xbox. Les produits de ce segment sont utilisés dans des appareils de jeu variés, tant pour les PC que pour les consoles.

Embedded (24%) : Les solutions embarquées d'AMD incluent des processeurs et des GPU pour des applications spécifiques comme les systèmes d'automatisation industrielle, les réseaux de télécommunications, les équipements médicaux, et diverses autres applications où la performance et l'efficacité énergétique sont cruciales. Ce segment vise à fournir des solutions de calcul adaptées à des environnements où l'espace et la consommation d'énergie sont limités.

Ces segments reflètent la stratégie d'AMD de diversifier son offre au-delà de la simple production originelle de CPU (processeur) pour ordinateurs de bureau et portables, en se positionnant comme un acteur clé dans plusieurs domaines technologiques de pointe.

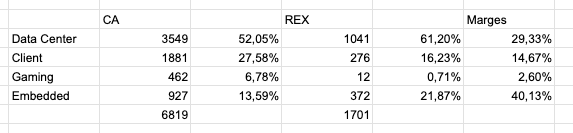

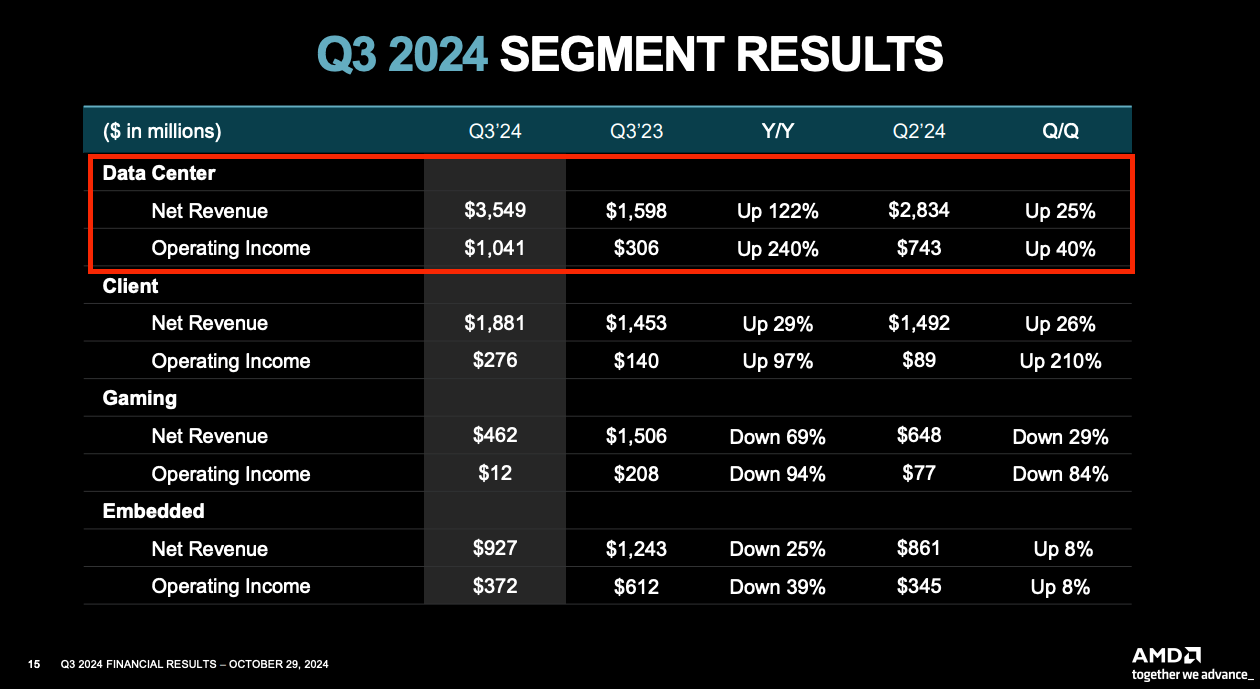

Alors que ce secteur évolue rapidement, les chiffres de 2023 ne représentent pas forcément bien ce qui soutient l’activité du groupe en ce moment. Par ailleurs, les marges sont différentes d’une activité à une autre. Voici les chiffres du 3e trimestres 2024 :

C’est bien la branche Data Center qui explose en ce moment, avec plus de 50% des ventes totales. Cette branche n’est pas la plus rentable du groupe en termes de marges (29%). C’est la branche Embedded avec des marges d’exploitation de 40%. Cependant, au vu de son importance, c’est bien la branche Data Center qui est la plus importante pour le groupe, alors qu’elle a généré 61% du résultat d’exploitation du groupe sur le 3e trimestre. Les branches clients et gaming sont plus cycliques et ont des marges moins importantes.

Ce qu’il faut retenir : AMD est en ce moment porté par le boom de l’IA, mais le groupe voit de fortes opportunités de croissance dans les data centers (grâce à l’IA), dans l'électronique grand public et dans sa branche Embedded. Dans cette dernière, si l’IA poursuit ses progrès, il est évident que de nombreuses machines plus intelligentes vont voir le jour, et que l’automatisation va s’accroître dans une multitude de domaines… Ainsi, il est vrai de dire que AMD est un play sur le développement de l’IA.

AMD vend des produits pour les data centers qui ont des besoins monstres du fait du développement de l’IA, mais aussi pour tous les robots intelligents via sa branche Embedded. Ce sont les deux branches à fort potentiel.

Le développement de l’IA, un boom à venir pour AMD ?

Le développement fulgurant de l’IA à travers tous les différents Chatgpt développés par les différents géants du web, mais aussi par différents indépendants, offre en théorie un potentiel immense pour AMD.

Si vous bidouillez un peu l’informatique, ou que vous avez bidouillé votre PC de gamer plus jeune, quelle est l’image que vous avez d’AMD ? Généralement, c’est que AMD est moins cher est presque aussi performant que Nvidia, le leader dans les cartes graphiques de gamer.

Dans l’IA, et les composants pour Datacenters… c’est sensiblement la même chose.

Dans l’IA, malgré le développement fulgurant de ce secteur ces deux dernières années, nous ne sommes encore qu’au début de cette révolution. Bien que le développement des différents ChatGPT ait déjà ébranlé certains segments du marché de l’emploi, il a le potentiel de chambouler de nombreux métiers qui se croient encore protégés de cette vague.

Tous les métiers dont le but est simplement de poser un diagnostique et d’appliquer une solution en se basant sur des connaissances, des données, sont à risque, car une intelligence artificielle le fera mieux et pour moins cher.

C’est ce qui va se passer avec la conduite autonome. C’est ce qui se passera dans de nombreux domaines.

Avec le développement des robots humanoïdes, beaucoup de métiers manuels simples vont aussi devenir à risque.

Les métiers créatifs ne sont pas autant à l’abri qu’on ne le pense.

Les métiers dit “qualifiés” ne sont pas spécialement plus à l’abri que les métiers dits “non qualifiés”. L’IA remplacera certainement beaucoup de choses, mais elle secondera aussi beaucoup de métiers.

In fine, je pense que la plupart des gens mesurent mal l’ampleur que va prendre l’intelligence artificielle dans nos vies.

La plupart des métiers et des secteurs seront concernés, et ceux dans lesquels elle se développera en priorité seront les secteurs en pénurie de main d’oeuvre, les secteurs où la pénibilité et la dangerosité sont importantes, et les secteurs les plus rémunérateurs.

Le développement de nos sociétés tournent autour de 2 choses : 1/ nous faciliter la vie et 2/ réduire les coûts.

Les IA serviront ces 2 buts dans de nombreux secteurs et dans de nombreuses industries.

A défaut de savoir comment votre métier actuel évoluera, je vais dans ce dossier parler d’un des vendeurs de pelles de cette révolution, l’américain AMD.

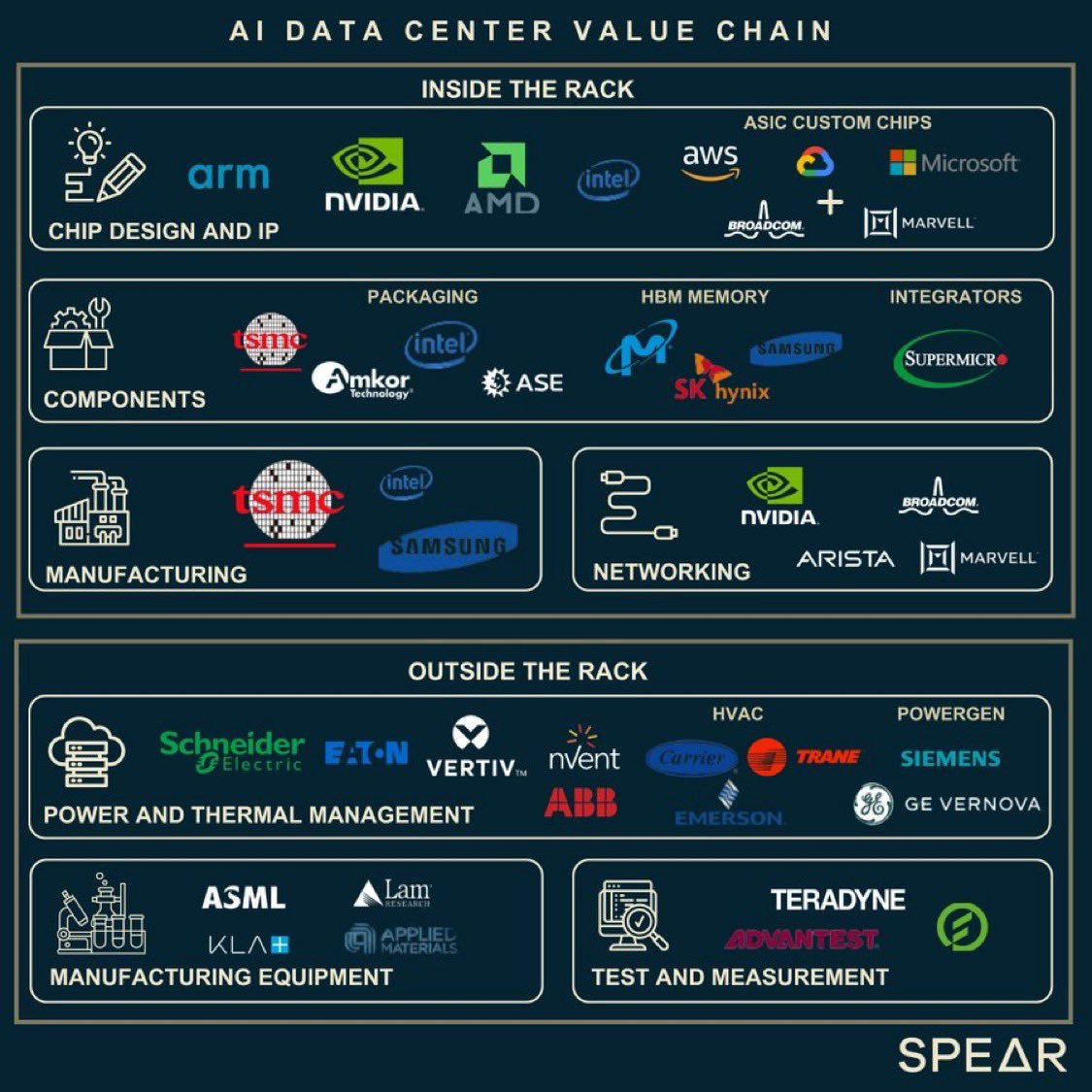

Une chaîne de valeur complexe

Au moment du boom d’Apple, tout le monde cherchait à savoir comment profiter de ce boom en pariant sur les sous-traitants.

Pour l’IA, c’est pareil.

ChatGPT est un peu l’équivalent d’Apple, à la différence que ChatGPT a quand même plusieurs gros concurrents du même niveau… et plein de petits ?

Derrière ChatGPT, et tous les acteurs en première ligne de ce secteur, il y a tous les fournisseurs de biens et de services de cette industrie.

A la différence d’Apple qui vendait essentiellement des produits physiques, l’IA vend des services en ligne.

Mais pour vendre ces services en ligne, elle a d’énormes besoins en termes de centre de données, les fameux “Data Center”.

Voici un exemple en vidéo de Data center de chez Google :

Les data centers sont donc une des variables clés du développement de ce secteur. Plus il y aura de datacenter, plus les IA pourront nous rendre service.

Bien évidemment, les data center sont de plus en plus efficaces. Un Data center d’aujourd’hui est au minimum, pour un coût équivalent, 3 à 5 fois plus puissant qu’un data center d’il y a 10 ans.

Cependant, les besoins en data center ont augmenté en raison du développement de l’IA de 10 à 20 fois sur les 10 dernières années. Par ailleurs, ces besoins pourraient encore être multipliés par 10 sur les 10 prochaines années selon les spécialistes à mesure de l’utilisation grandissante des différentes IA dans nos vies.

Il est très difficile de chiffrer précisément le nombre de data center qui vont se construire sur les 10 prochaines années, la puissance qu’il faudra en termes d’électricité etc. alors que la technologie tant des data center que des logiciels IA évoluent vite.

Cependant, à l’image du projet Américain Stargate qui vient d’être lancé par plusieurs géants du web et de l’IA, qui veut investir 500 milliards de dollars en 4 ans dans des datacenters destinés à l’IA, nous ne sommes visiblement qu’au début de ce cycle d’investissement. Plusieurs géants du Web comme Microsoft, Alphabet, Meta ou encore Amazon ont aussi annoncé d’importants investissements dans ce domaine sur les prochaines années.

Sachant, que les Etats-Unis sont en avance sur le reste du monde, on est en droit de penser que nous sommes bien juste au tout début de ce cycle d’investissement qui touchera avec retard l’Europe et l’Asie.

Bref, voici un récap synthétique de la chaine de valeur des data center liés à l’intelligence artificielle.

Dans toute cette chaîne de valeur, pourquoi AMD ?

AMD n’est pas, et ne serait pas mon seul choix de valeur si je voulais miser sur l’envol de ce secteur.

Cependant, AMD m’intéresse car les composants que cette société fabrique sont au coeur de cette révolution, et AMD me semble avoir une valorisation raisonnable.

Les forces d’AMD ?

Nvidia est le leader incontesté dans les composants pour les data center liés à l’IA.

Cependant, AMD n’est pas loin derrière, et a plusieurs points forts par rapport au développement de l'IA.

AMD propose tout d’abord une vaste gamme de produits qui couvrent différents segments du marché de l'IA, allant des serveurs de centres de données (avec les processeurs EPYC et les accélérateurs AMD Instinct) aux PC (avec les processeurs Ryzen et les GPU Radeon). Cette diversité permet à AMD de répondre à une variété de besoins en IA, de l'inférence (je reviens sur cette notion juste après) à grande échelle dans le cloud à l'IA sur les appareils de bord.

AMD utilise également des architectures comme AMD CDN pour les accélérateurs de GPU, RDNA pour les graphiques, et XDNA pour les moteurs d'IA intégrés dans les processeurs Ryzen AI, ce qui leur donne une flexibilité et une performance accrues pour les charges de travail d'IA. De plus, AMD s'engage dans un écosystème logiciel ouvert et des collaborations avec des frameworks populaires, ce qui facilite le développement et le déploiement de solutions d'IA.

Les produits d'AMD sont souvent aussi mis en avant pour leur efficacité énergétique et leur performance, notamment avec l'introduction de nouvelles générations de processeurs et d'accélérateurs qui visent à offrir de meilleurs performances par watt, ce qui est crucial pour le développement de l’IA à grande échelle alors que la création de capacité de production électriques est plus lente.

Nvidia mène bien la danse avec un écosystème logiciel et matériel très optimisé pour l'IA, une forte présence sur le marché et des performances de pointe, cependant, AMD se distingue par son approche plus ouverte, la diversité de son portefeuille de produits, et une compétitivité accrue en termes de prix et d'efficacité énergétique.

L'inférence, ce qui peut faire exploser AMD ?

L'inférence dans l'intelligence artificielle fait référence au processus par lequel un modèle d'IA utilise les connaissances qu'il a apprises lors de la phase d'entraînement pour faire des prédictions, des classifications ou des décisions sur de nouvelles données non vues auparavant.

Jusqu’à maintenant, les modèles d’IA étaient la plupart du temps entraînés sur une base de données à l’instant T.

A l’avenir, les modèles d’IA vont de plus en plus utiliser l’inférence pour prendre des décisions et produire des solutions, et ce, avec un volume de données toujours plus important, et un laps de temps toujours plus court. Cela devrait une nouvelle fois accélérer de nombreuses tâches, mais aussi en réduire les coûts. Le Dr House de notre siècle ne sera pas un surhomme, ce sera certainement une IA.

L'inférence doit souvent être rapide et efficace, surtout dans des applications en temps réel comme la reconnaissance vocale, la détection d'objets dans les véhicules autonomes, ou les recommandations de produits pour les utilisateurs. Cela contraste avec la phase d'entraînement, qui peut être extrêmement gourmande en ressources et en temps.

Dans ce segment, AMD semble être très bien positionné. Par exemple, Meta a choisi d’avoir exclusivement des composants AMD pour gérer les activités en temps réel de son modèle Llama.

Les activités en temps réel, c’est de l’inférence en temps réel… c’est ce qu’il y a de plus complexe… et Meta a choisi des composants AMD pour le faire. Un bon point. Meta et AMD ont d’ailleurs établi un partenariat de long terme dans lequel AMD va fournir en priorité à Meta ses composants les plus avancés destinés à l’inférence.

Pourquoi ce choix de la part de Meta ? Visiblement, la plateforme de développement utilisée par AMD permet d’avoir plus de mémoire que la concurrence directement dans les Accélérateurs, en l’occurrence les MI300X, ce qui leur permet d’être plus rapides, et donc moins chers.

Meta se sert de son IA pour renforcer les prédictions de ces différentes applications (par exemple, la prochaine vidéo instagram qu’on va vous suggérer).

Alors que Meta n’est sans doute pas à la pointe de l’IA type ChatGPT, basée sur des phases d’entraînement, Meta est peut-être en avance dans l’IA basée sur l’inférence en temps réel, qui est le domaine d’avenir de l’IA. De ce fait, avoir ce client est un beau fait d’arme pour AMD.

Le fait d’être apparemment en avance dans ce domaine est un bon signe pour la suite, car AMD pourra se servir de son expérience pour développer différentes verticales sur ce segment et répondre aux différents besoins de ces marchés. Dans ce domaine, AMD semble également avoir une approche plus personnalisable, ce qui pourrait séduire davantage de clients à l’avenir, et permettre une croissance des marges.

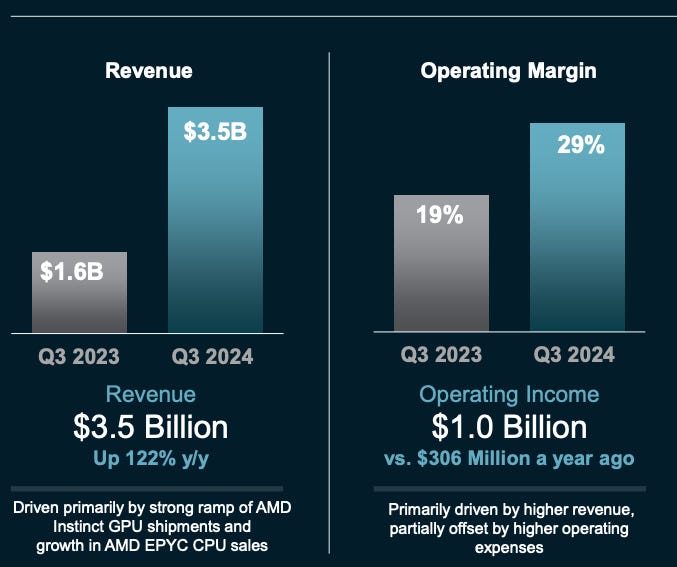

En attendant que l’Inference devienne un des moteurs de la croissance du groupe, la croissance de la branche Data Center est déjà très forte…

Ce qui permet une forte croissance des marges de cette branche.

Le edge computing, l’autre domaine d’avenir de AMD ?

Derrière la branche “Embedded”, ce sont tous les composants qui servent à l’intelligence embarquée.

Pour ChatGPT, vous vous connectez à un serveur, un data center, qui va résoudre votre problème grâce à l’IA, et vous renvoyer la réponse.

Cependant, beaucoup de robots dans des usines, de voitures autonomes, doivent “réfléchir” sur place, et n’ont pas le temps de poser leurs problèmes à un super-calculateur basé dans un datacenter.

Bref, dans cette branche, c’est l’essor de la robotique intelligente qui va porter l’activité, ou l’on a besoin de puissance de calcul “sur place”.

Les voitures autonomes sont un exemple, mais il y a aussi la robotique dans les usines, la surveillance et la sécurité (reconnaissance faciale etc.), la santé (analyse en temps réel des signes vitaux sans avoir besoin d’une connexion internet etc.

C’est dans cette branche qu’a été intégré Xilinx, qui est le leader de la technologie des FPGAs (Field-Programmable Gate Arrays). L'expertise de Xilinx dans les FPGAs et les SoCs (System on Chip) programmables renforce considérablement la position d'AMD dans les secteur du calcul haute performance, des réseaux, de l'automobile, de l'aérospatiale, et de nombreuses autres industries où l'adaptabilité et la performance personnalisée sont cruciales.

Un exemple concret de ou peuvent servir ces produits, car moi, j’ai besoin de concret 😅, les derniers produits FPGA vont être utilisés dans la prochaine génération de Satellites de SpaceX… encore un client des plus exigeants gagné dans un domaine d’avenir. Tesla utilise aussi dans ses véhicules des FPGA d’AMD dans les systèmes de vision, de gestion de la batterie, et d'autres fonctions de contrôle en temps réel.

La suite logique de tout ça c’est que AMD semble avoir un avantage dans ce qu’on appelle le “Edge AI”, qu’on pourrait traduire par l’IA de terrain, c’est à dire de l’IA qui est directement intégré dans un système intelligent, un robot, une voiture autonome, et qui permet à ce système d’avoir des réponses bien plus rapide, que s’il devait faire appel à un serveur dans un data center.

Ce qu’il faut retenir : en termes de produits, AMD semble bien placé sur l’inference, qui semble être la grosse tendance d’avenir pour les data center d’IA, mais aussi dans les composants pour l’intelligence embarquée, un autre domaine d’avenir très important. Les 2 autres branches du groupe, Client et Gaming, devraient continuer de croître, mais c’est bien les branches Data Center et Embedded qui ont le potentiel de faire exploser la croissance du groupe sur les prochaines années.

Et Nvidia dans tout ça ?

Nvidia est le leader incontesté.

C’est Nvidia qui a sorti en premier et qui sort les produits les plus puissants pour les Data Center liés à l’IA.

C’est aussi Nvidia qui a pour le moment les meilleurs logiciels. Sur ce point, plusieurs experts pointent du doigt que les logiciels de Nvidia sont pour le moment supérieurs à la concurrence et plus utilisés, mais ils sont surtout assez fermés. Si vous couplez ces logiciels assez fermés et la position dominante du groupe sur ce marché qui a créé un effet réseau important chez les fournisseurs et les clients, vous pouvez pensez à raison que Nvidia n’est pas prêt de céder sa position dominante sur ce marché.

Est-ce que les derniers GPU Blackwell de Nvidia sont meilleurs que les équivalents de chez AMD ?

Une question pas si évidente.

Blackwell promet d'être un leader en termes de performance brute et d'efficacité énergétique pour les applications de pointe en IA, mais AMD avec son Instinct MI300X offre des solutions très compétitives, surtout quand on considère l'ensemble des facteurs comme le coût, l'écosystème logiciel, et les besoins spécifiques en termes de charge de travail. Chaque entreprise a ses forces, et le "meilleur" dépend en réalité des besoins précis de l'utilisateur, du budget, des logiciels existants et des performances requises pour des tâches spécifiques.

In fine, les produits ne sont pas forcément très éloignés, et AMD devrait certainement gagner des contrats pour des questions de coûts, de besoins spécifiques etc. Mais c’est bien Nvidia le leader. C’est Nvidia qui doit continuer en théorie de surfer sur cette vague grâce aux meilleurs produits et aux meilleurs logiciels. AMD doit continuer d’être le numéro 2 qui va gagner petit à petit des marchés grâce à différents facteurs.

En 2024, AMD a gagné plusieurs clients significatifs pour ses GPUs IA, comme Meta, IBM, ou encore chez les fournisseurs de serveurs comme Dell, HPE, Lenovo ou Supermicro. Ces contrats et partenariats semblent montrer une tendance où AMD commence à gagner du terrain dans le marché des GPUs dédiés à l'IA, bien que Nvidia reste le leader en termes de part de marché global.

❌ Pourquoi je suis finalement négatif sur ce secteur ?

Je n’ai pas encore parlé de valorisation mais je viens de faire une démonstration synthétique sur les fondamentaux de pourquoi Nvidia devrait continuer de bien se porter et pourquoi AMD devrait aussi suivre Nvidia dans son sillage.

J’ai dis “devrait” car c’est globalement ce que pense en ce moment le marché de ces deux valeurs.

Elles ont chacune des qualités et doivent en théorie continuer de surfer sur cette vague, alors qu’elles sont les vendeuses de pelles principales de ce secteur.

Cependant, il y a un problème.

A la différence de la ruée vers l’or en Californie en 1848, ou les vendeurs de pelles ont fait fortune en vendant des pelles, car il n’y avait de toute façon que peu d’innovation pour chercher de l’or, et donc pour faire concurrence à la pelle, le secteur de l’IA est caractérisé par des innovations bien plus rapides.

Quand on pense innovation dans ce secteur, on peut penser à Nvidia qui sort chaque année de nouveaux produits bien plus performants, on peut penser aux différents ChatGPT qui répondent de façon toujours plus précise et poussée aux requêtes, mais on pense beaucoup moins… à l’optimisation du code.

Jusqu’à maintenant, le marché pense globalement que les besoins en calcul d’IA ne vont faire qu’augmenter car on va utiliser ces langages de plus en plus partout avec un volume de données toujours plus important.

Cependant, on ne prend pas en compte l’évolution de ces langages. Pour ceux qui codent et qui me lisent, vous voyez très bien ce dont je veux parler. Quand vous avez codé votre premier truc, ça marchait, super, mais ce n’était pas un code optimisé. Avec l’expérience, si vous devez re-coder cet élément, il y a fort à parier que vous allez réduire le nombre de ligne par 2 ou 3 pour le même résultat. Ainsi, votre code est plus rapide et va consommer moins de puissance de calcul.

C’est ce qui va se passer avec l’IA et les langages LLM.

Pour le moment, d’un point de vue maturité du code des Grand modèle de langage (LLM) qui font fonctionner les IA, nous sommes certainement juste au niveau de Windows 95 dans les systèmes d'exploitation. C’est un truc qui marche bien, mais qui n’est pas rapide et qui demande de gros serveurs pour tourner.

Sur les prochaines années, les progrès sur ce point vont être fulgurants, et ce qui risque de se passer, c’est que cette importante optimisation du code, malgré un volume de données plus important à traiter, va conduire à une forte baisse des dépenses d’équipements dans le secteur de l’IA.

Vous voulez un exemple ? OK.

Connaissez vous Deepseek ?

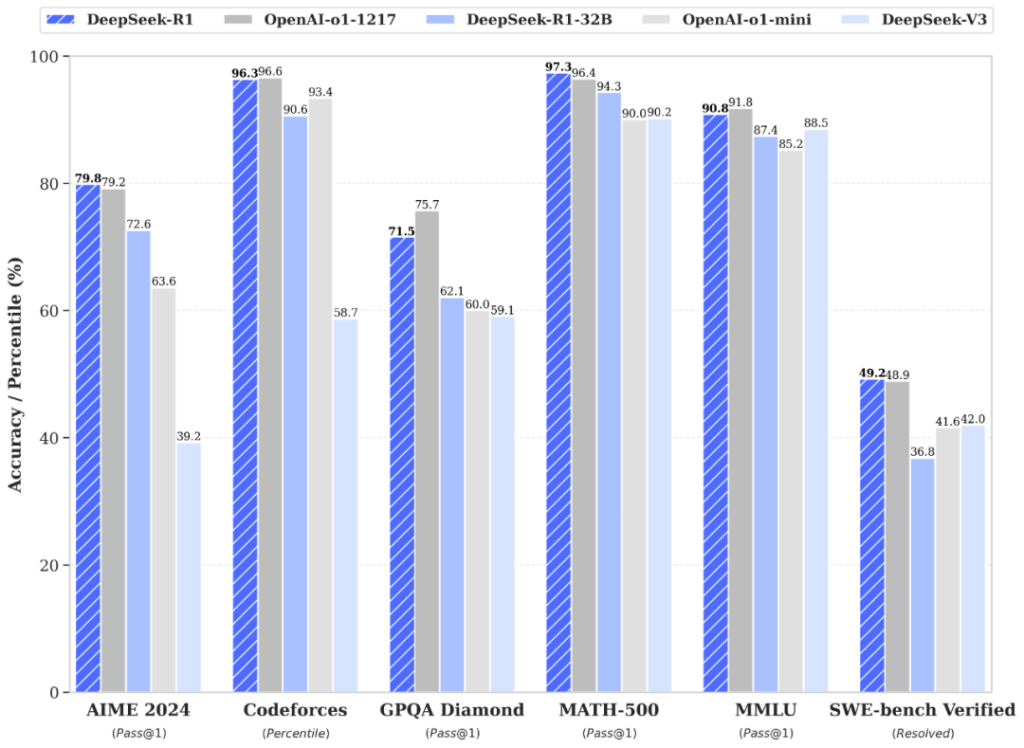

Deepseek est un ChatGPT chinois qui a lancé récemment son dernier langage DeepSeek-R1 qui a la particularité d’être visiblement aussi bien, voire meilleur, que la dernière version de ChatGPT dénommée o1, qui est considéré comme le LLM le plus abouti.

Cette IA est visiblement capable de raisonner et produire des réponses précises dans de nombreux domaines. Ses points forts seraient actuellement les mathématiques, la génération de code, mais aussi le raisonnement contextuel.

Selon les tests menés par DeepSeek, leur IA R1 bat o1 sur les benchmarks AIME, MATH-500 et SWE-bench Verified. Elle n’est aussi, pas loin derrière, sur les autres…

👉 Bref, voici une IA qui arrive à faire aussi bien, voire mieux, que le géant du secteur !

Les 3 autres particularités ?

La première, c’est que DeepSeek publie ses langages LLM en Open Source, c’est-à-dire que tout le monde peut les copier, s’en servir pour améliorer son code, et s’en servir commercialement. Ce n’est pas le cas de Open AI… dont le code n’est pas “Open”, mais bien fermé ! Deepseek vient possiblement de détruire la valeur des autres LLM équivalent.

La deuxième, c’est que le modèle de Deepseek a été entraîné pour un coût estimé de 5,58 M$. Il s'agit d'une somme particulièrement basse pour un modèle de cette ampleur et de cette performance. Pour comparaison, ChatGPT 4 a nécessité plusieurs centaines de millions de dollars. Certains doutent de ces chiffres mais en attendant, le modèle est open source et tout le monde peut le télécharger et vérifier.

La troisième, c’est que Deepseek arrive à rivaliser avec des modèles comme GPT-4 ou Claude-3.5 Sonnet pour une fraction du coût typique des grands modèles de langage. En l’état actuel des choses, l’API de Deepseek, qui permet d’avoir accès à DeepSeek-R1, le langage le plus élaboré, est 30 à 100 fois moins cher que l’accès à la version la plus élaborée de ChatGPT. Le fait que l’accès à l’API de Deepseek coûte beaucoup moins cher tend à confirmer que c’est un modèle low cost.

👉 Les forces de Deepseek sont que ses modèles de langage sont souvent optimisés pour la vitesse et qu’ils coûtent bien moins chers à entraîner, et donc à “produire”. C’est l'utilisation de l'architecture "Mixture-of-Experts" (MoE) dans ses modèles LLM qui permet de réduire considérablement la puissance de calcul nécessaire pour l'inférence.

Ce qu’il faut retenir : Deepseek est peut-être un exemple très concret que dans ce domaine, on peut faire aussi bien que les géants, pour une fraction du coût !

OpenAI a levé environ 9 Mrds$ en financement direct, sans compter les investissements non publiés ou les partenariats stratégiques comme avec Microsoft.

Et là, pour 5,5 M$, une IA chinoise arrive à faire aussi bien.

Nous sommes en droit de douter des déclarations de cette IA chinoise mais le fait que son code soit librement disponible sur Github, prouve qu’ils n’ont rien à cacher. C’est même le message inverse qui est envoyé. Allez-y, testez-moi !

Les conséquences ? 💥

La domination d’Open AI sur les langages LLM pourrait être bien plus faible que prévu. C’est donc tout ce secteur qui est fragilisé sur l’aspect “produit”. Je pense ici aussi à Anthropic (Claude), Google DeepMind (et Google AI), Meta (Llama, Llama 2), xAI (Grok), mais aussi Mistral AI. Le MOAT, les fameux remparts, serait bien plus faible que prévu.

Le business de ces différents créateurs de langage pourrait être bien moins rentable que prévu, voire même pas rentable ? Deepseek démontre en ce moment qu’on peut faire un LLM très performant et pas cher, ce qui peut aller à l’encontre de tous ceux qui pensaient en faire un business très rentable. Cela peut inciter à la prudence tous les investisseurs qui sont sollicités pour investir dans ces entreprises, ou pour construire des Data Centers…

Les dépenses d’équipements dans ce domaine pourraient être bien moins importantes que prévu. Tous les géants de ce secteur sont certainement, à l’heure ou je vous parle, en train de disséquer le code de Deepseek, qui est Open Source et accessible librement sur Github. Ils vont certainement piquer toutes les bonnes idées pour améliorer et donc optimiser leur code, ce qui pourrait réduire drastiquement les coûts de fonctionnement de leur IA, à l’image de ce qu’à fait Deepseek. Ainsi, l’aspect positif serait que tous les ChatGPT pourraient réduire drastiquement leurs coûts de fonctionnement, et donc leurs besoins en serveur.

➡️ De ce fait, pour Nvidia et AMD, c’est potentiellement tout le story telling boursier sur le fait que les dépenses d’investissement de la part de tous les géants du web qui veulent faire de l’IA ne vont que croître qui est en train de disparaître à court terme.

On peut même se demander si la course aux équipements n’a pas conduit tous les géants du secteur à en avoir trop par précaution, et donc, et à devoir arrêter leurs commandes drastiquement très rapidement à court terme. C’est ce qui s’est passé par exemple avec Sartorius Stedim Biotech lors du Covid, ou tous les fabricants de vaccins ont passé d’énormes commandes d’équipements par peur de manquer, puis en ont finalement eu trop ! Actuellement, il n’y a plus de pénurie de composants GPU comme à un certain moment, les commandes sont livrées rapidement, signe que le marché est peut-être bientôt saturé en équipement dernier cri.

Si on se met à la place de tous les dirigeants de ce secteur qui ont investi des montants énormes, et qui prévoient d’investir encore beaucoup sur les prochaines années, si le code évolue bien dans la direction des LLM de Deepseek, c’est à dire un LLM qui a besoin de beaucoup moins de serveurs pour tourner et qui est “pas cher”, tous ces dirigeants vont avoir beaucoup de mal à justifier ces investissements massifs, qui seront finalement beaucoup moins rentables.

Il y a déjà beaucoup de questions sur le potentiel de rentabilité de toutes ces activités de LLM, et Deepseek vient peut-être de ternir un peu les espérances des pures player de ce secteur.

Cela ne veut pas dire que Nvidia ou AMD ne vendront plus du tout de GPU pour des data centers mais cela veut peut être dire que sur les prochaines années, il va y avoir un gros creux en termes de demandes pour tous ces équipementiers de l’IA, ce qui se traduira par une baisse de la demande, au mieux une croissance moins forte, au pire une baisse de la demande, une guerre des prix, on n’achète plus n’importe quoi à tout prix, et on est plus en mesure de négocier des baisses de prix, ce qui se traduira par une baisse des marges.

➡️ Bref, je pense que l’arrivée de Deepseek, et d’autres Deepseek qui vont challenger les gros acteurs sur leurs fondements, est une bonne chose pour nous les consommateurs, c’est une bonne chose pour tous les LLM qui sauront en tirer parti, mais c’est une mauvaise chose pour les vendeurs d’équipements à court terme, pour les LLM fermés et pour les entreprises qui ont trop investi dans ce domaine.

Je ne suis pas le seul à le penser :

J’ai dis à court terme car les utilisations des LLM ne vont pas disparaître, c’est tout le contraire, et l’inference va gagner en importance avec de nombreuses LLM qui seront en partie disponibles sur des objets du quotidien, votre smartphone, votre voiture etc. Par ailleurs, il y aura toujours besoin de GPU à moyen terme, car la durée de vie des GPU dans un data center d’intelligence artificielle n’est que de 3 à 5 ans !

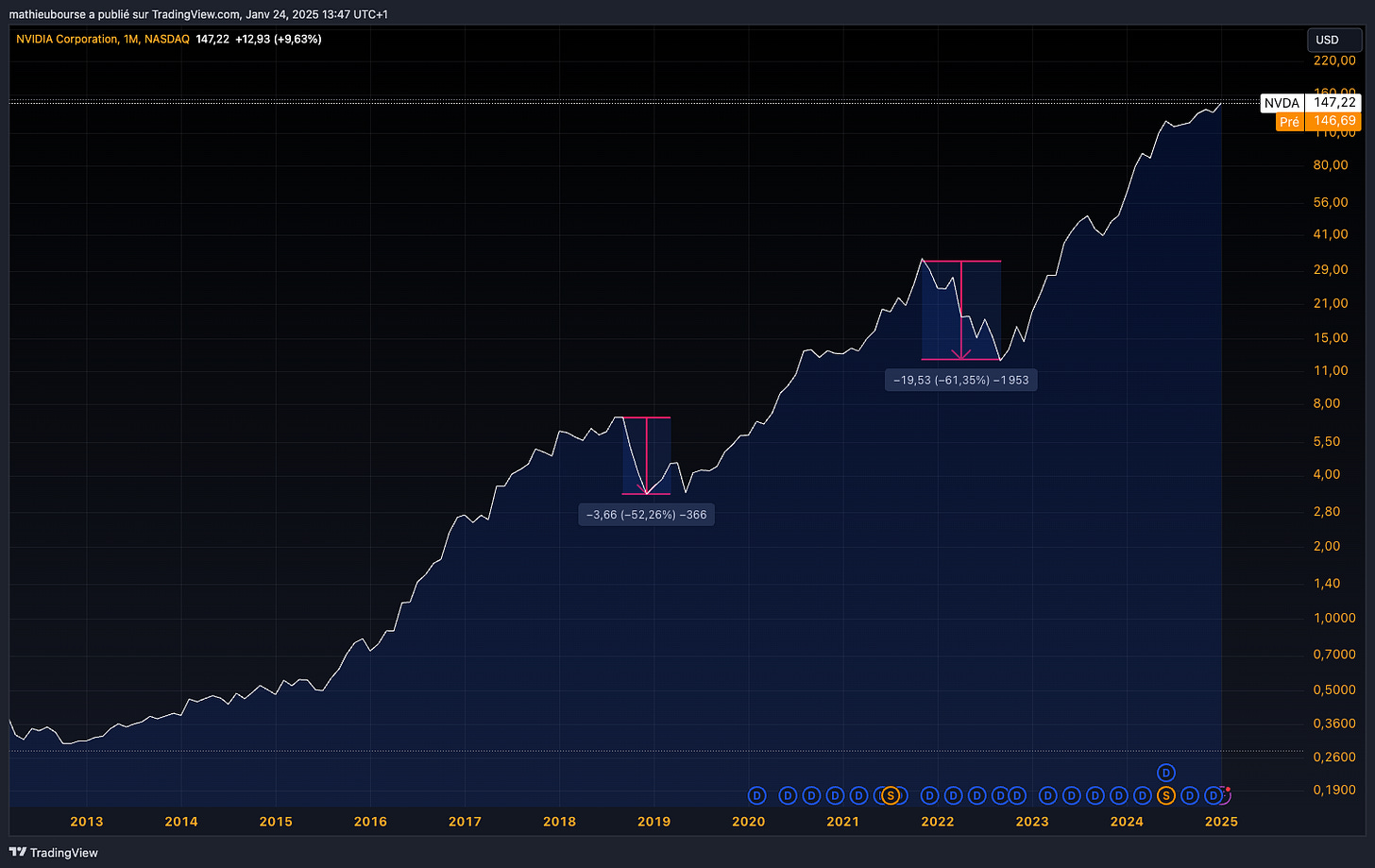

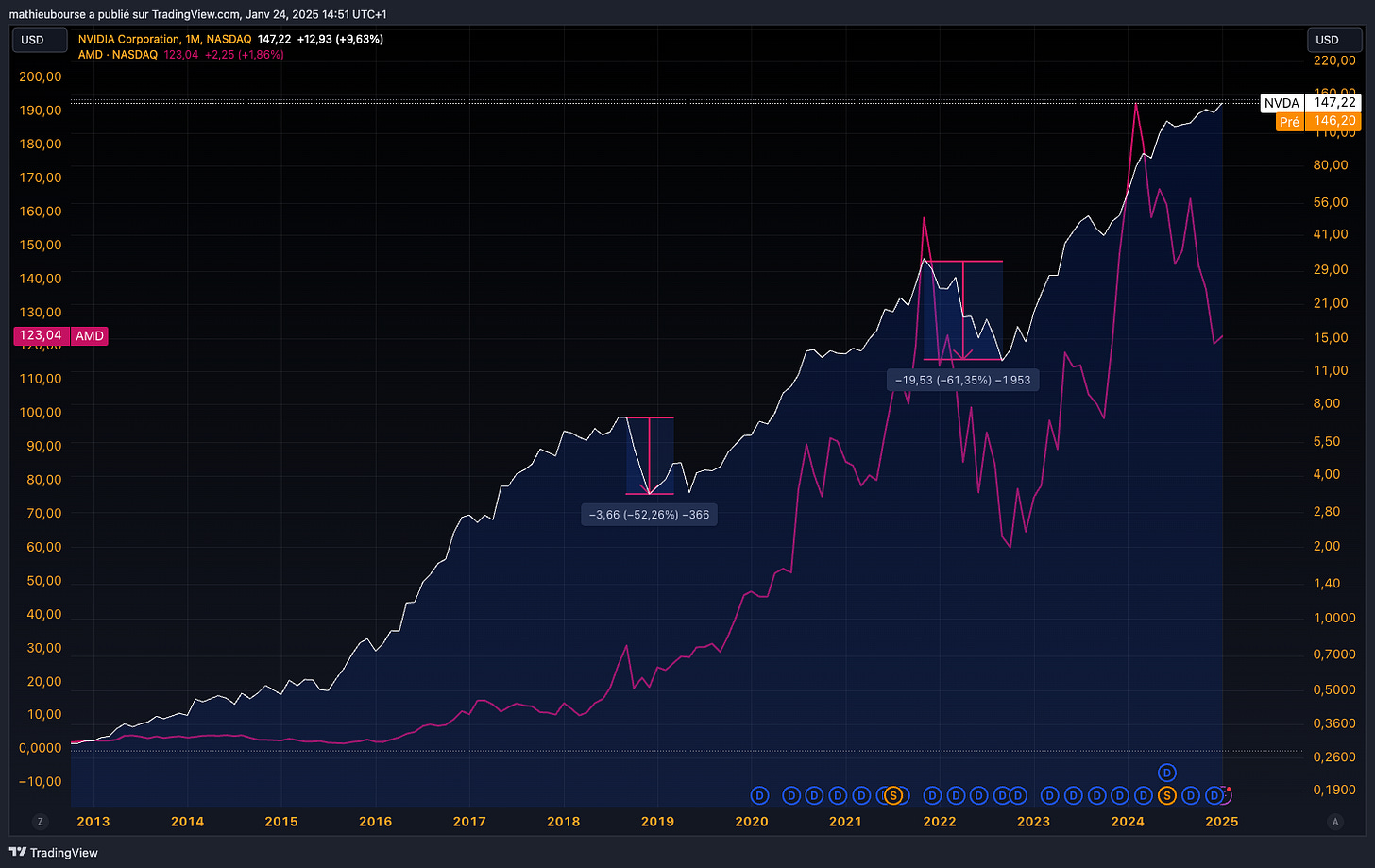

➡️➡️➡️ De ce fait, ce que j’estime possible sur Nvidia et AMD, c’est un fort trou d’air d’un point de vue demande sur les 2/3 prochaines années, qui pourrait se traduire par un fort trou d’air en Bourse, à l’image de ce qui s’est passé fin 2018 (-52%) et fin 2021 début 2022 (-61%) sur Nvidia : ⤵️

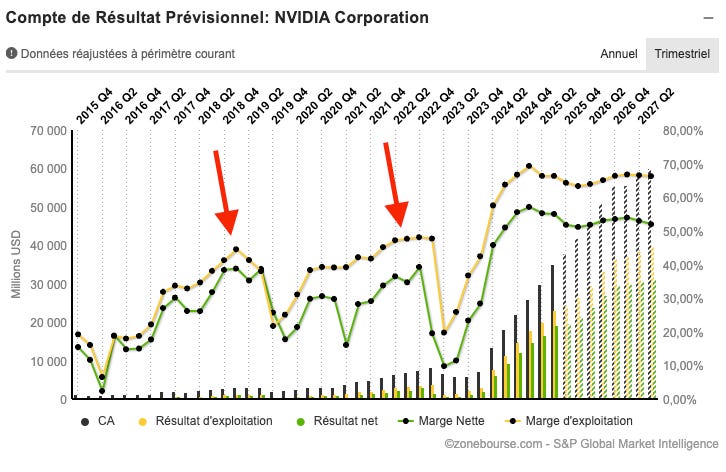

Ces forts trou d’air en bourse étaient justifié à chaque fois par un pic de demande puis une chute sur plusieurs mois : ⤵️

Et concernant AMD… elle a souvent suivi Nvidia… (courbe rose)

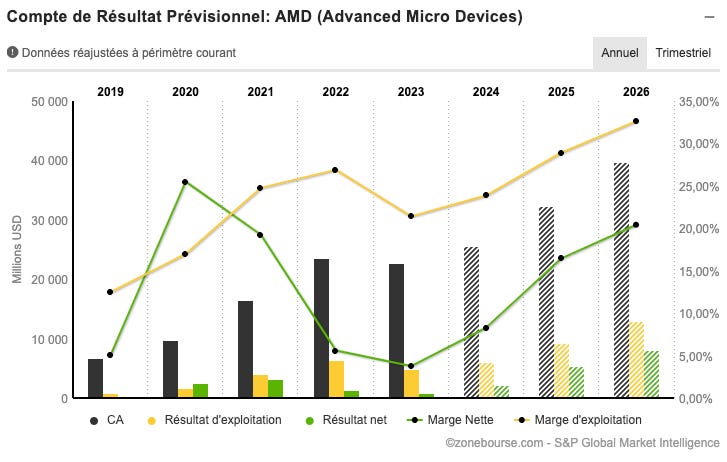

La baisse du cours de bourse d'AMD depuis février 2024 peut être attribuée à plusieurs facteurs, mais principalement des prévisions décevantes, des problèmes de chaîne d’approvisionnement, une valorisation tendue, et peut-être une dynamique moins favorable dans l’électronique grand public.

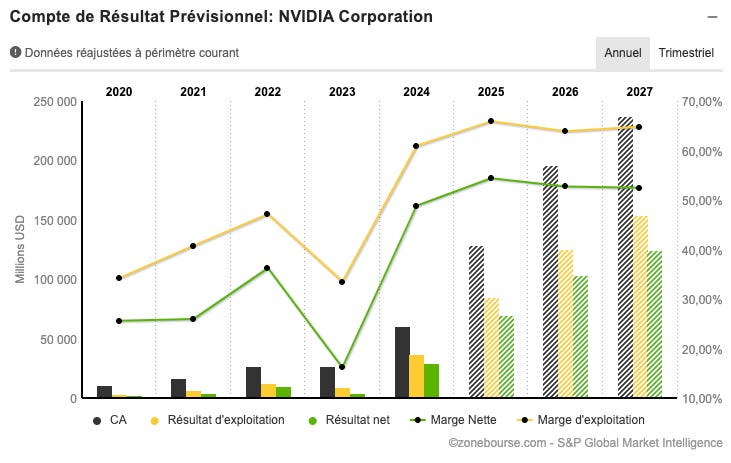

Nvidia se négocie 27,4x les bénéfices 2027…

AMD, c’est 27,5x les bénéfices 2027.

Dans les 2 cas, le risque est une grosse révision en baisse des perspectives de croissance et de marges sur les 2/3 prochaines années !

Et chaque fois que cela s’est produit sur ces 2 valeurs… les investisseurs n’ont pas bien réagi.

💥 Les enseignements pour mon portefeuille

Sur AMD et Nvidia 🇺🇸

A moyen/long terme, je reste très positif sur AMD, qui est moins exposé à l’IA que Nvidia, et qui a un portefeuille d’activité plus diversifié, avec notamment une forte position dans le edge computing et l’inference.